Em 1942, um dos colegas de Robert Oppenheimer o procurou com uma hipótese preocupante: caso seu trabalho no Projeto Manhattan fosse bem sucedido e eles construíssem a primeira bomba atômica do mundo, era bem possível que a explosão colocaria fogo no céu.

Abalado, Oppenheimer contou isso para uma das pessoas mais experientes do projeto, Arthur Compton, que respondeu com horror, de acordo com uma biografia de Oppenheimer: “Havia realmente qualquer chance de que uma bomba atômica desencadeasse a explosão do nitrogênio na atmosfera ou do hidrogênio no oceano? Esta seria a catástrofe final. É melhor aceitar a escravidão dos nazistas do que dar a chance de fechar a cortina final sobre a humanidade!”.

Compton disse a Oppenheimer que “a menos que eles chegassem a uma conclusão firme e confiável que as nossas bombas atômicas não poderiam explodir o ar ou o mar, essas bombas não deveriam ser feitas”. A equipe fez uma série de cálculos, decidiu que os dados matemáticos lhe davam apoio suficiente e que o “dispositivo”, como a bomba era conhecida, era seguro. O trabalho continuou. Ainda assim, no local do teste Trinity, no Novo México, em 16 de julho de 1945, um dos cientistas apostou com os outros se “a bomba iria ou não inflamar a atmosfera e, em caso afirmativo, se destruiria apenas o Novo México ou o mundo”. Por sorte, ainda não foi daquela vez que nosso planetinha foi pelos ares.

Na verdade, não foi por sorte. Oppenheimer, um físico teórico brilhante, e sua equipe tinham certeza do que estavam fazendo antes de o fazerem. Com a sua avaliação de risco, Oppenheimer criou inadvertidamente um novo campo de estudo: o risco existencial.

Instituto do Futuro da Humanidade

Setenta anos depois do teste Trinity, tais avaliações de risco ainda são realizadas. Baseados em instituições acadêmicas no Reino Unido e nos Estados Unidos, herdeiros espirituais do Projeto Manhattan trabalham intensamente em relativa obscuridade. Não há muitos deles. Eles já não estão construindo bombas. Eles vêm de todos os tipos de disciplinas – agora também da filosofia, além das ciências exatas. Seu objetivo é nada menos do que salvar a raça humana de destruir a si mesma.

Liderado por Nick Bostrom, o filósofo sueco famoso por popularizar os riscos de inteligência artificial, o Instituto do Futuro da Humanidade (FHI, do inglês Future of Humankind Institute) é parte da Escola Martin de Oxford, criada quando um bilionário da computação deu a maior doação em 900 anos de história da Universidade de Oxford para que fosse criado um lugar para resolver alguns dos maiores problemas do mundo. Um dos artigos de Bostrom observou que há mais pesquisas acadêmicas sobre besouros de estrume e Star Trek do que sobre extinção humana. O FHI está tentando mudar isso.

O instituto fica no primeiro andar – ao lado do Centro para o Altruísmo Efetivo – de um prédio de escritórios nada distinto. No lobby principal, há uma enorme lousa de vários lados, rabiscada com anotações, gráficos, tabelas e um pequeno memorial para James Martin, o doador bilionário, que morreu em 2013.

“Em um nível intelectual, temos este conjunto central de objetivos: tentar descobrir o que realmente importa para o futuro da maior parte da humanidade e, em seguida, o que podemos pesquisar sobre isso?”, explica um dos afiliados do FHI, o sueco Anders Sandberg. “O sucesso real seria ter uma ideia para tornar o mundo melhor. Ou mesmo descobrir em que direção fica esse ‘melhor'”.

Qual o maior perigo?

Hoje, nossa maior dor de cabeça é a tecnologia. As Nações Unidas estão tentando nos impedir de matar uns aos outros com robôs autônomos no aqui e agora. Em um eco do Projeto Manhattan, a criação do recém-reiniciado Grande Colisor de Hádrons – o acelerador de partículas feito pelo homem sob a França e a Suíça – levantou temores sobre a criação de um buraco negro na Terra. (Assim como a equipe de Oppenheimer, os pesquisadores do LHC fizeram várias avaliações de risco sobre a probabilidade de acabar com o mundo. Deve ficar tudo bem conosco).

Outras ameaças potenciais são mais difíceis de detectar. Em 2012, cientistas tentavam fazer estirpes de gripe mutante ficarem mais letais e foram forçados a rever algumas de suas descobertas. No ano passado, o governo dos Estados Unidos parou de financiar mais pesquisas nesta área. Isso se deveu em grande parte à campanha de cientistas de risco existencial como Martin Rees, o fundador do Centro para o Estudo do Risco Existencial (CSER), o homólogo da Universidade de Cambridge para o FHI.

“A biotecnologia envolve equipamentos em pequena escala e de dupla utilização. Milhões, um dia, terão a capacidade de abusar dela”, diz Rees. Seu maior medo? “Algum fanático da ecologia, habilitado pela perícia da bio-pirataria que em breve poderá ser rotineira, que acredita que ‘Gaia’ está sendo ameaçada pela presença de muitos seres humanos”.

E a inteligência artificial?

Por outro lado, algumas das coisas que a maioria das pessoas acredita ser um risco existencial podem não ser um drama tão grande. Bill Gates, Elon Musk e Stephen Hawking, bem como o próprio Bostrom, já alertaram para os perigos de criar um computador com superinteligência. Na cultura popular, já vimos máquinas que escravizam seres humanos em filmes como “Matrix” e “O Exterminador do Futuro”, além de muitos outros. Mas isso é algo que os estudiosos de Oxford não consideram uma ameaça iminente.

“O que os engenheiros estão fazendo agora com a aprendizagem de máquina não é realmente assustador”, afirma outro pesquisador do FHI, Daniel Dewey, um norte-americano especializado em superinteligência de máquinas.

E quando a preocupação é a extinção humana, o nível do que conta como uma catástrofe é brutalmente alto. Tomemos, por exemplo, o aquecimento global. “A mudança climática pode constituir um risco existencial se for pior do que o esperado e haja um ciclo de regeneração que faça com que as temperaturas subam até 20 °C”, aponta Andrew Snyder-Beattie, gerente de projeto do FHI. No momento, estamos caminhando para um aumento 2 a 4 °C.

“[Mesmo assim] você poderia viver neste mundo padrão de mudança climática”, complementa Sandberg. “Um monte de cidades teriam água na rua e um monte de pessoas seriam realocadas e nosso padrão de vida seria muito mais baixo, mas a nossa existência pode ser bastante boa. O nosso futuro é mais do que apenas o próximo século. Talvez os próximos séculos sejam realmente ruins e, em seguida, comece a glória”.

Clubinho de gênios

Pesquisadores de risco existencial muitas vezes se veem frustrados com a rigidez de seus campos de estudo. Seth Baum criou o Instituto Global de Risco Catastrófico (GCRI, do inglês Global Catastrophic Risk Institute) em Nova York (EUA) para tentar mudar isso. Sempre houve acadêmicos preocupados com a sobrevivência humana, diz Baum. “O que tem sido relativamente recente é o surgimento de uma comunidade que não é especificamente focada em um risco, ou um conjunto de riscos, mas uma ampla categoria deles”, destaca.

O GCRI, a CSER e o FHI formam a trindade desta comunidade. Há pouca rivalidade – a palestra mais recente do CSER, intitulada “Será que vamos causar nossa própria extinção? Riscos de extinção natural versus antropogênica”, foi dada pela Toby Ord, do FHI. “Mas ainda é uma comunidade muito pequena, dada a escala e amplitude dos problemas que precisam ser abordados”, aponta Rees, astrofísico de 72 anos e astrônomo real da Grã-Bretanha, que dirige o CSER quando não está ocupado na Câmara dos Lordes.

Muito além no futuro

Pensar no futuro, então, não se torna uma conversa teórica, mas uma questão ética. “Alguns dos principais triunfos que temos alcançado como uma civilização tem a ver com a mudança de nossos padrões morais”, Dewey acrescenta. “Nós já não achamos que é aceitável ir à guerra com um país e, em seguida, apagar a sua população da face da Terra. Já não pensamos que a escravidão é aceitável e acreditamos que as mulheres devem ter direitos iguais aos homens”.

Em outras palavras, nós vamos salvar a raça humana não nos preocupando com inteligência artificial ou pandemias, mas por entender por que vale a pena nos salvar, antes de mais nada. Os pesquisadores de risco existencial estão, na verdade, tentando fazer com que nos importemos tanto com nossos descendentes quanto nos preocupamos com nós mesmos.

Snyder-Beattie descreve isso como ações de sensibilização para o “valor ético das gerações futuras”. Rees gosta de citar o ecologista E. O. Wilson, que disse uma vez: “Causar extinções em massa é pelo que as gerações futuras menos nos perdoarão”.

O futuro do mundo nas suas mãos

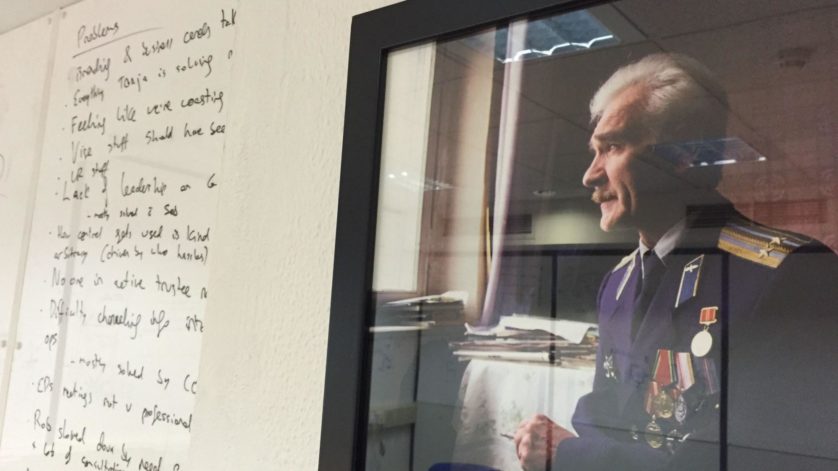

Em uma das salas de conferências do FHI em Oxford, há um retrato de um militar com um bigode espesso e uma expressão triste. Esse homem é Stanislav Petrov, que era o oficial de plantão em um bunker perto de Moscou em uma noite em setembro de 1983, quando seu computador lhe disse que os EUA tinham acabado de lançar quatro mísseis nucleares na União Soviética. O protocolo era para Petrov chamar seus superiores e preparar o contra-ataque; em outras palavras, a Terceira Guerra Mundial. Em vez disso, Petrov ignorou o alarme.

“Se eu tivesse enviado o meu relatório até a cadeia de comando, ninguém teria dito uma palavra contra”, disse ele à BBC 30 anos depois. Na mais banal das circunstâncias, Petrov assegurou que a humanidade ainda estivesse aqui agora. Fala-se em nomear uma outra sala de conferências no FHI em homenagem a Vasili Arkhipov, outro russo a bordo de um submarino nuclear soviético que parecia estar sob ataque, no auge da crise dos mísseis em Cuba, em 1962. Era necessário que os três comandantes decidissem por lançar uma bomba nuclear; Arkhipov foi o único que se recusou.

É revelador que mavericks como Petrov e Arkhipov sejam os heróis para esses pesquisadores, não Oppenheimer – que, em 1960, visitou o Japão e, de acordo com uma biografia vencedora do Prêmio Pulitzer, comentou friamente: “Eu não me arrependo de ter tido algo a ver com o sucesso técnico da bomba atômica”.

Sobre Petrov, Sandberg disse: “Há algo de simbólico a respeito de indivíduos que melhoraram seriamente as perspectivas para a raça humana. [O retrato] também serve para nos lembrar que talvez – é improvável, mas talvez um dia -, você pode se encontrar em uma situação semelhante, na qual o destino do mundo depende do que você faz”. [Quartz]